بعد عقود من الضجيج حول السيارات الطائرة، شهدت السنوات العشر الأخيرة تحولاً إلى تصميم منتج يشبه الهجين ما بين السيارة والطائرة: طائرة كهربائية تقلع وتهبط عمودياً «eVTOL» توفر خدمة تشبه خدمة سيارات الأجرة.

هذا من الناحية النظرية - لأن كل ما لدينا حالياً، مثلاً، لمشاهدة طائرة «eVTOL» وهي تنقل شخصاً ما إلى مطار لوس أنجليس الدولي، هي عرض فيديو مُنتج بواسطة الحاسوب.

ولكن بعد سنوات من الخدمات الواعدة التي لم تنطلق بعد، تحتاج الشركات الناشئة في مجال هذه السيارات الطائرة إلى تجاوز مجرد إثارة إعجاب المستثمرين. كما أن عليها أن تثبت للجهات التنظيمية أنها قادرة على تقديم خدمة آمنة وموثوقة في المجال الجوي المزدحم بالفعل. ثم عليها أن تكسب ثقة العملاء الذين لديهم خيارات نقل أخرى. ويبقى رهانها الأساسي على أن عدداً كافياً من الناس سينفقون مبالغ كبيرة محتملة لتوفير الوقت ليس رهاناً مجنوناً... ولكنه ليس أمراً مؤكداً كذلك.

انطلاق العمليات

لفهم الفجوة بين العرض التوضيحي الخاص والخدمة العامة الفعلية، نأخذ على سبيل المثال شركة «جوبي أفييشن»، وهي شركة مقرها سانتا كروز بولاية كاليفورنيا، التي تقول إنها على وشك إطلاق عملياتها التجارية في غضون أشهر. في مؤتمر «قمة الويب» الذي عُقد في نوفمبر (تشرين الثاني) الماضي في لشبونة بالبرتغال، عرضت الشركة رؤيتها لمستقبل مجال «eVTOL». إذ أكد إريك أليسون، رئيس قسم المنتجات بالشركة قائلاً: «هذا ليس مجرد عرض، هذه ليست مجرد فكرة».

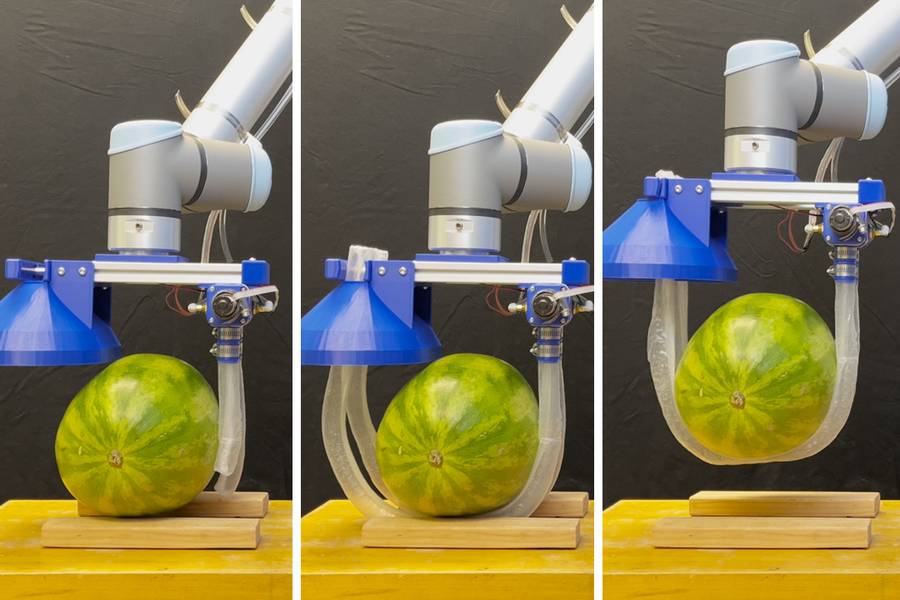

غير أن أول حالة استخدام عرضها لم تتضمن نقل الأشخاص إلى مطار سان فرانسيسكو الدولي. بدلاً من ذلك، تحدث عن كيف يمكن لطائرة «eVTOL» من إنتاج شركة «جوبي» ذات المراوح الست - والتي تتسع لأربعة ركاب وطيار، وتصل سرعتها إلى 200 ميل في الساعة، وتوفر مدى أقصى يبلغ 150 ميلاً بعد الشحن - أن تحل محل رحلة السيارة التي كانت تُقله من ماونتن فيو إلى وسط مدينة سان فرانسيسكو. وقال: «تلك الرحلة التي كانت تستغرق مني ساعة ونصف الساعة يومياً قد تستغرق 15 دقيقة فقط إذا لم نسلك الطريق البري وإنما بالطيران».

لكن فكرة ازدحام أعداد كبيرة من الناس في سيارات الأجرة الجوية للوصول إلى منطقة تجارية مزدحمة لا يمكن تطبيقها على نطاق واسع.

وتحدث أليسون بالتفصيل عن خطط شركة «جوبي» لتقديم الخدمة إلى المطارات - وهي وجهات تتميز بالفعل بمرافق هبوط وتوزيع حركة المرور بشكل أكثر توازناً على مدار اليوم - وعن شراكاتها مع شركات الطيران من شاكلة «دلتا إيرلاينز»، و«فيرجين أتلانتيك»، و«أول نيبون إيروايز». وتوقع أليسون إتاحة خدمة الركاب في دبي هذا العام الجديد، وشدد على أن شركة «جوبي» لا تطير بفكرة وهمية: «هذا شيء نباشر تنفيذه بالفعل».

في مقابلة بعد عرضه التقديمي، قدم نسخة أكثر واقعية من عرض شركة «جوبي» لسيارة الأجرة الجوية الكهربائية «إس 4» التي تعمل بالبطارية. تشمل طموحات الشركة لطائراتها الكهربائية العمودية «eVTOL» النقل الجوي السريع للأثرياء، وهو أمر تبحثه شركة «جوبي» بالفعل من خلال شركة الطائرات المروحية «بليد إير موبيليتي - Blade Air Mobility» التي اشترتها في أغسطس (آب) الماضي في صفقة بلغت قيمتها 125 مليون دولار.

أعلنت شركة «بليد»، في نوفمبر (تشرين الثاني)، عن بدء رحلات طيران هليكوبتر خلال أيام الأسبوع بين مطار مقاطعة ويستشستر ومانهاتن بأسعار تتراوح بين 125 و225 دولاراً للرحلة الواحدة. وصرح أليسون إن الشركة تهدف إلى التغلب على هذه الأسعار من خلال خدمة «eVTOL» الخاصة بها، وبدلاً من ذلك، فإنها ستطابق تقريباً أسعار خدمة «أوبر بلاك - Uber Black» على أساس كل مقعد. وقال: «نعتقد أن هناك إمكانات هائلة في أغلب المدن الكبرى المزدحمة للغاية، ليس في الولايات المتحدة فقط، وإنما في جميع أنحاء العالم».

لا تعتبر «أوبر» مجرد نقطة مقارنة وإنما شريك؛ في عام 2021، اشترت شركة «جوبي» قسم «أوبر إليفيت - Uber Elevate» التابع لشركة «أوبر» لخدمات النقل التشاركي، في حين زادت «أوبر» من استثماراتها في شركة «جوبي» من 50 مليون دولار إلى 125 مليون دولار، ووافقت على دمج خدمات شركة «جوبي» المستقبلية في تطبيقاتها.

لا يفترض نموذج أعمال شركة «جوبي» أن البرمجيات ستحل محل الطيار البشري، على الرغم من أن أليسون أقر بأنه «على المدى الطويل، نعتقد أن القيادة الذاتية تلعب دوراً كبيراً في هذا الأمر».

المنافسة وضعف البنية التحتية

ولكن الرحلات إلى المطار تشكل الجزء الأكبر من عرض شركة «جوبي». وعلى هذا الصعيد، أقر أليسون بأن الشركة سوف يتعين عليها التنافس مع خيارات النقل الحالية. وقال أليسون: «نحن لا نسعى لاستبدال وسائل النقل العام. وإنما نحن نصنع خياراً جديداً يتمتع بميزات فريدة لا يمكنك الحصول عليها عبر أي من وسائل النقل الأخرى».

أولى هذه الميزات هي السرعة، ولكن هناك أيضاً المنظر الذي يستمتع به ركاب خدمة «بليد» اليوم، يقول أليسون: «يمكنك الاستمتاع بمنظر رائع لأفق المدينة أثناء الطيران فوق النهر والتحليق للذهاب إلى المطار». بالنظر إلى أسعار «بليد» - يذكر موقعها الإلكتروني أن أسعار الرحلات من مانهاتن إلى مطار جون كنيدي تتراوح بين 195 و295 دولاراً - فمن الأفضل أن تكون هذه الإطلالة استثنائية.

في الآونة ذاتها، حددت «أوبر» سعرا يبلغ نحو 145 دولاراً لرحلة «أوبر بلاك» من وسط مانهاتن إلى مطار جون كنيدي و100 دولار لرحلة «أوبر إكس» في وقت مبكر من بعد ظهر يوم الثلاثاء من أسبوع عيد الشكر. أما تكلفة ركوب مترو أنفاق نيويورك أو قطار لونغ آيلاند إلى «إير ترين» - الذي يربط بين أنظمة النقل هذه ومطار جون كنيدي (مسار من محطتين أقل ملاءمة وأكثر تكلفة من خيارات القطار إلى المطار في شيكاغو أو واشنطن أو سان فرانسيسكو) - فتبلغ ما بين 11.40 دولار و15.50 دولار لمعظم الركاب.

وسوف تتطلب رحلات طائرات «eVTOL» الفعَّالة سلسلة طويلة من الموافقات من مشغلي البنية التحتية والسلطات المحلية. يبدو أن الأسهل هو إبرام اتفاقيات مع المطارات لتبسيط عملية نقل الركاب بعيداً عن مداخل الركاب المعتادة. وقال أليسون إن شركة «جوبي» تعمل مع شركة «دلتا» وشركاء آخرين من شركات الطيران في هذا الشأن. وأضاف أن شركة «جوبي» تفترض أن النقل من المطار سيحتاج إلى وقت حتى يتمكن المسافرون من اجتياز إجراءات الأمن في مبنى المغادرة. وفي الوقت نفسه، ستحتاج طائرات «eVTOL» إلى وقت لشحن البطارية بسرعة في غضون 10 دقائق.

سوف تحتاج شركة «جوبي» أيضاً إلى بناء مطارات عمودية لطائراتها في الأسواق المستهدفة، وهو ما سيكون أكثر تعقيداً بكثير من توفير مساحة لعملياتها في المطارات.

الحصول على إجازة الطيران

وفي يوم إعلان أرباحها، أعلنت الشركة أنها بدأت في إجراء اختبارات التشغيل للطائرة الأولى المصممة وفقاً للتصميم النهائي الذي ستحتاج إدارة الطيران الفيدرالية «FAA» إلى اعتماده. تهدف شركة «جوبي» إلى إجراء رحلات تجريبية، بقيادة طياريها وطياري إدارة الطيران الفيدرالية. ورفض أليسون التنبؤ بموعد إصدار إدارة الطيران الفيدرالية شهادة النوع لطائرة «eVTOL».

وتبحث الشركة عن طرق لبدء عمليات ما قبل التجارية في دبي قبل الحصول على تلك الشهادة. وبصفة عامة، تتصور خطط شركة «جوبي» أن شهادة إدارة الطيران الفيدرالية ستكون بمثابة توطئة لاعتماد سلامة الطيران في أماكن أخرى.

في الولايات المتحدة، سيتعين على أي شركة «eVTOL» العمل مع نظام مراقبة حركة الطيران الذي يعاني بالفعل من ضغوط. قال أليسون إن محاكاة شركة «جوبي» مع إدارة الطيران الفيدرالية تظهر أن عملياتها قابلة للتنفيذ «مع تعديلات طفيفة على الإجراءات الحالية». ولكن بعد عام من حوادث مراقبة الحركة الجوية التي شملت اصطداماً مميتاً في الجو بالقرب من مطار واشنطن العاصمة الوطني في يناير (كانون الثاني) من العام الماضي، لا ينبغي أن تتوقع شركة «جوبي» الحصول على تصريح سريع لخدمتها، وسيكون من الحكمة أن تلتزم بعقلية وصفها أليسون بأنها «الزحف، والمشي، ثم الجري».

* مجلة «فاست كومباني»، خدمات «تريبيون ميديا»