عندما انتشر تطبيق «تشات جي بي تي» على نطاق واسع، سارعت فرق قيادة الشركات إلى فهمه، لكن موظفيها سبقوها في ذلك؛ إذ كان الموظفون يُجرّبون بالفعل أدوات الذكاء الاصطناعي سراً، مستخدمينها لتلخيص الملاحظات، وأتمتة المهام، وتحقيق أهداف الأداء بموارد محدودة، كما كتب سيندي رودريغيز كونستابل(*)... وما بدأ كأداة لتعزيز الإنتاجية بشكل مختصر، تطوّر إلى معيار جديد في مكان العمل.

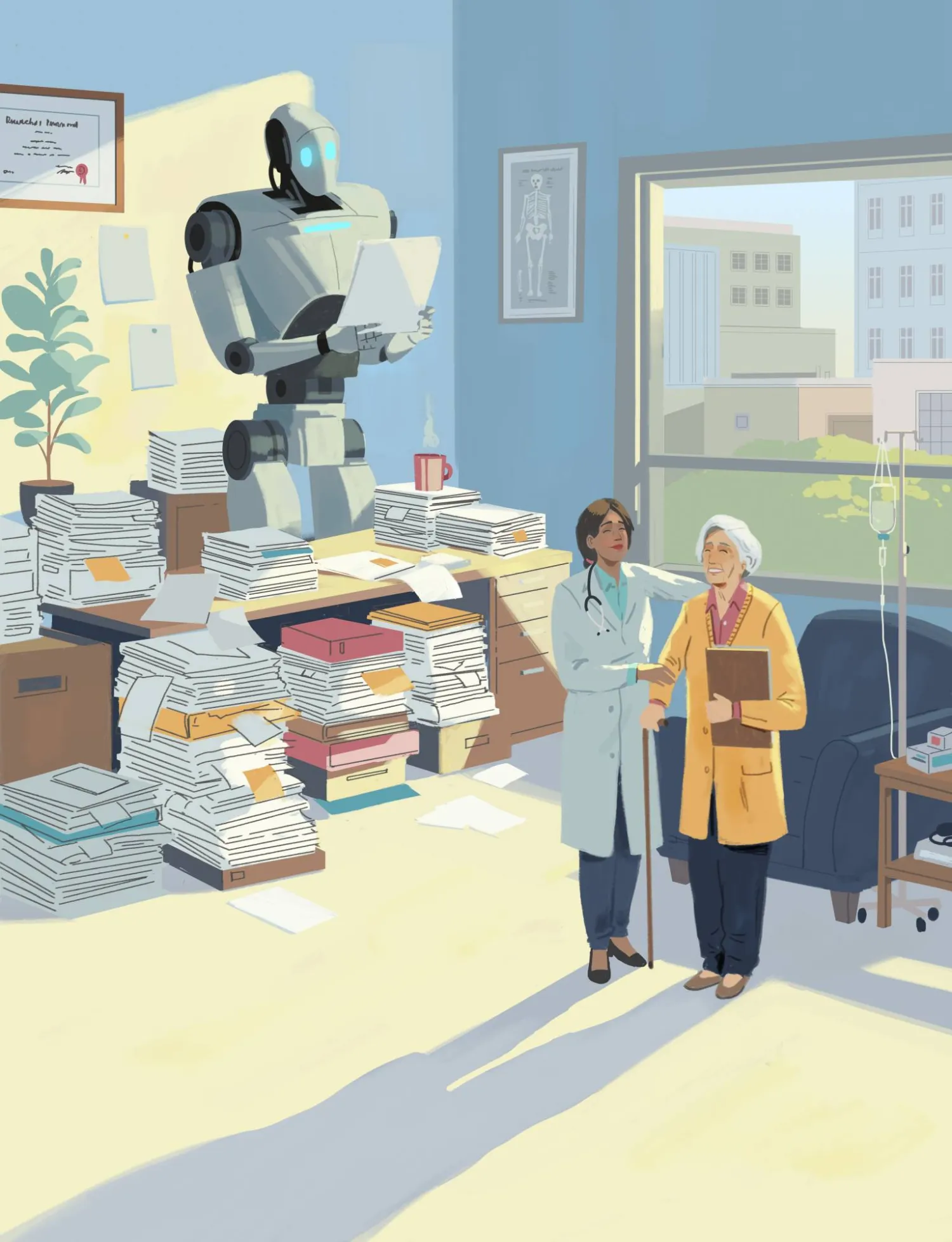

الموظفون يستخدمون «ذكاءهم الاصطناعي»

وفقاً لمؤشر اتجاهات العمل من «مايكروسوفت»، يستخدم ثلاثة من كل أربعة موظفين الذكاء الاصطناعي في العمل، ويُحضر ما يقرب من 80 في المائة من مستخدمي الذكاء الاصطناعي في الشركات الصغيرة والمتوسطة أدواتهم الخاصة إلى مكان العمل، وتبلغ هذه النسبة 78 في المائة في الشركات الأكبر. وتتراوح هذه الأدوات من مُولّدات النصوص، مثل «جي بي تي»، إلى منصات الأتمتة وبرامج التصميم المُدعّمة بالذكاء الاصطناعي.

وتُعرف هذه الظاهرة التصاعدية باسم «أحضر ذكاءك الاصطناعي الخاص»، أو BYOAI إنه يعكس الأيام الأولى لسياسات «إحضار جهازك الخاص» (BYOD)، عندما بدأ الموظفون باستخدام هواتفهم الذكية وأجهزة الكمبيوتر المحمولة الشخصية لمهام العمل - غالباً قبل أن يضع أصحاب العمل بروتوكولات لإدارتها. وقد تطورت تلك السياسات في النهاية لمعالجة مخاوف الأمان وخصوصية البيانات والتحكم في الوصول. ولكن مع BYOAI، تكون المخاطر أعلى.

خوارزميات خارجية تجتاح أماكن العمل

بدلاً من الأجهزة المادية، يُدخل الموظفون خوارزميات في سير العمل؛ خوارزميات لم يتم فحصها من قبل قسم تكنولوجيا المعلومات الخاص بالشركة، أو الامتثال للقواعد، أو الشؤون القانونية. وفي ظل المناخ التنظيمي السريع الحركة اليوم، يمكن أن يُشكل ذلك مخاطر جسيمة؛ فقد اعترف ما يقرب من نصف الموظفين الذين يستخدمون الذكاء الاصطناعي في العمل بأنهم يفعلون ذلك بشكل «غير لائق»، مثل ثقتهم في جميع الإجابات التي يقدمها الذكاء الاصطناعي دون التحقق منها، أو تكليفه بمعلومات حساسة.

إن هذه التوجهات ليست سلوكاً هامشياً أو بدعة تقنية عابرة. إنها واقع سريع النمو في أماكن العمل الحديثة، مدفوعاً بالموظفين المرهقين، والفرق ذات الموارد المحدودة، وإمكانية الوصول المتزايدة إلى أدوات الذكاء الاصطناعي القوية.

وفي غياب سياسات أو رقابة، يتولى الموظفون زمام الأمور بأنفسهم، مستخدمين في كثير من الأحيان أدوات يجهلها أصحاب العمل. ورغم أن الهدف قد يكون تعزيز الإنتاجية، فإن هذا قد يُعرّض الشركات لتسريب البيانات ومشاكل أمنية أخرى.

6 من 10 موظفين أخطأوا بسبب الذكاء الاصطناعي

وسواء كان فريق للتسويق يُدخل بيانات العملاء في روبوت محادثة، أو رئيس فرقة عمليات يُؤتمت سير العمل باستخدام مكونات إضافية، فإن هذه الأدوات قد تفتح الباب بهدوء أمام انتهاكات الخصوصية، واتخاذ قرارات متحيزة، وانهيار العمليات.

يقول ما يقرب من ستة من كل عشرة موظفين إنهم ارتكبوا أخطاء في العمل بسبب أخطاء الذكاء الاصطناعي، كما أن كثيرين يستخدمونه بشكل غير صحيح (57 في المائة يعترفون بأخطائهم، و44 في المائة يُسيئون استخدامه عن عمد).

ومع ذلك، ووفقاً لتقرير صادر عن ديلويت عام 2024، الذي استطلعت فيه آراء المؤسسات الرائدة في مجال الذكاء الاصطناعي، أفادت 23 في المائة فقط من هذه المؤسسات بأنها تشعر بالاستعداد التام لإدارة المخاطر المتعلقة بالذكاء الاصطناعي. ووفقاً لشركة «KPMG»، فإن 6 في المائة فقط من الشركات لديها فريق متخصص يُركز على تقييم مخاطر الذكاء الاصطناعي وتطبيق إجراءات السلامة.

وتقول أليسون سبانيولو، كبيرة مسؤولي الخصوصية والمديرة الإدارية الأولى في شركة «غايدبوست سوليوشن»، المتخصصة في التحقيقات والامتثال التنظيمي والاستشارات الأمنية: «عندما يستخدم الموظفون خدمات الذكاء الاصطناعي الخارجية دون علم أصحاب العمل... فإننا نميل إلى التفكير في مخاطر مثل فقدان البيانات، وتسريب الملكية الفكرية، وانتهاكات حقوق النشر، والخروقات الأمنية».

كيف تتقدم الشركات ذات الرؤية المستقبلية؟

بدأت بعض المؤسسات في الاستجابة - ليس بحظر الذكاء الاصطناعي، بل بالعمل على تمكين الموظفين من استخدامه.

ووفقاً لتقرير ديلويت، تستثمر 43 في المائة من المؤسسات التي تستخدم الذكاء الاصطناعي في عمليات تدقيق داخلية للذكاء الاصطناعي، وتُدرّب 37 في المائة منها المستخدمين على إدراك المخاطر والتخفيف منها، وتُحافظ 33 في المائة منها على سجل رسمي لكيفية استخدام جيل الذكاء الاصطناعي، حتى يتمكن المديرون من القيادة بوضوح، دون ارتباك.

وفي الوقت نفسه، تُزوّد «سيلزفورس» الموظفين بأدوات ذكاء اصطناعي آمنة ومعتمدة، مثل «سلاك للذكاء الاصطناعي Slack AI» و«آينشتاين Einstein»، التي تتكامل مع أنظمة البيانات الداخلية، مع الحفاظ على قيود صارمة على استخدام البيانات الحساسة وتقديم تدريب منتظم. لدى الشركة أيضاً إطار عمل لتقديم المشورة للشركات الأخرى حول كيفية وضع سياساتها الخاصة للاستخدام الداخلي للذكاء الاصطناعي.

تقول رينا ريشترمير، الشريكة في «CM Law PLLC»، وهي شركة متخصصة تُقدم الاستشارات للعملاء بشأن قضايا التكنولوجيا الناشئة: «إن أفضل استراتيجية هي في الواقع فتح قنوات التواصل مع الموظفين». وتضيف أنه لا ينبغي لأصحاب العمل رفض استخدام الذكاء الاصطناعي، بل عليهم بدلاً من ذلك تزويد الموظفين بحواجز ومعايير وتدريب. على سبيل المثال، قد يطلب أصحاب العمل من الموظفين استخدام البيانات العامة فقط و«استبعاد البيانات التي تُعتبر ملكية خاصة أو سرية تجارية أو متعلقة بالعملاء».

استخدام الذكاء الاصطناعي الخاص بك لن يختفي

إن استخدام الذكاء الاصطناعي الخاص بك ليس مجرد توجه تقني، بل هو تحدٍّ قيادي.

يجد المديرون أنفسهم الآن يشرفون على إنتاجية كلٍّ من البشر والآلات، غالباً دون تدريب رسمي على كيفية إدارة هذا المزيج بفاعلية. يجب عليهم تحديد متى يكون الذكاء الاصطناعي مناسباً، وكيفية تقييم استخدامه، وضمان الالتزام بالمعايير الأخلاقية ومعايير الأداء.

ثقافات استباقية

كما أن أفضل ما يمكن للشركات فعله هو التحول من السياسات التفاعلية إلى ثقافات استباقية؛ إذ يحتاج الموظفون إلى تواصل واضح حول ما هو آمن وما هو محظور، وأين يلجأون للحصول على التوجيه.

وتقول سبانيولو: «أعتقد أن وجود سياسة مخصصة للاستخدام المقبول للذكاء الاصطناعي مفيد للغاية... يمكنك إخبار موظفيك بدقة بالتوقعات، وما هي المخاطر التي قد تنجم عن تجاوزهم لهذه السياسة، وما هي العواقب».

والشركات التي ستستفيد أكثر من الذكاء الاصطناعي هي تلك التي تفهم كيفية تمكين موظفيها من استخدام الذكاء الاصطناعي والابتكار من خلاله. وهذا يتطلب من القادة التحول من سؤال الموظفين: «هل تستخدم الذكاء الاصطناعي؟» إلى «كيف يمكننا دعمك لاستخدامه بشكل جيد؟».

* مجلة «فاست كومباني» - خدمات «تريبيون ميديا»