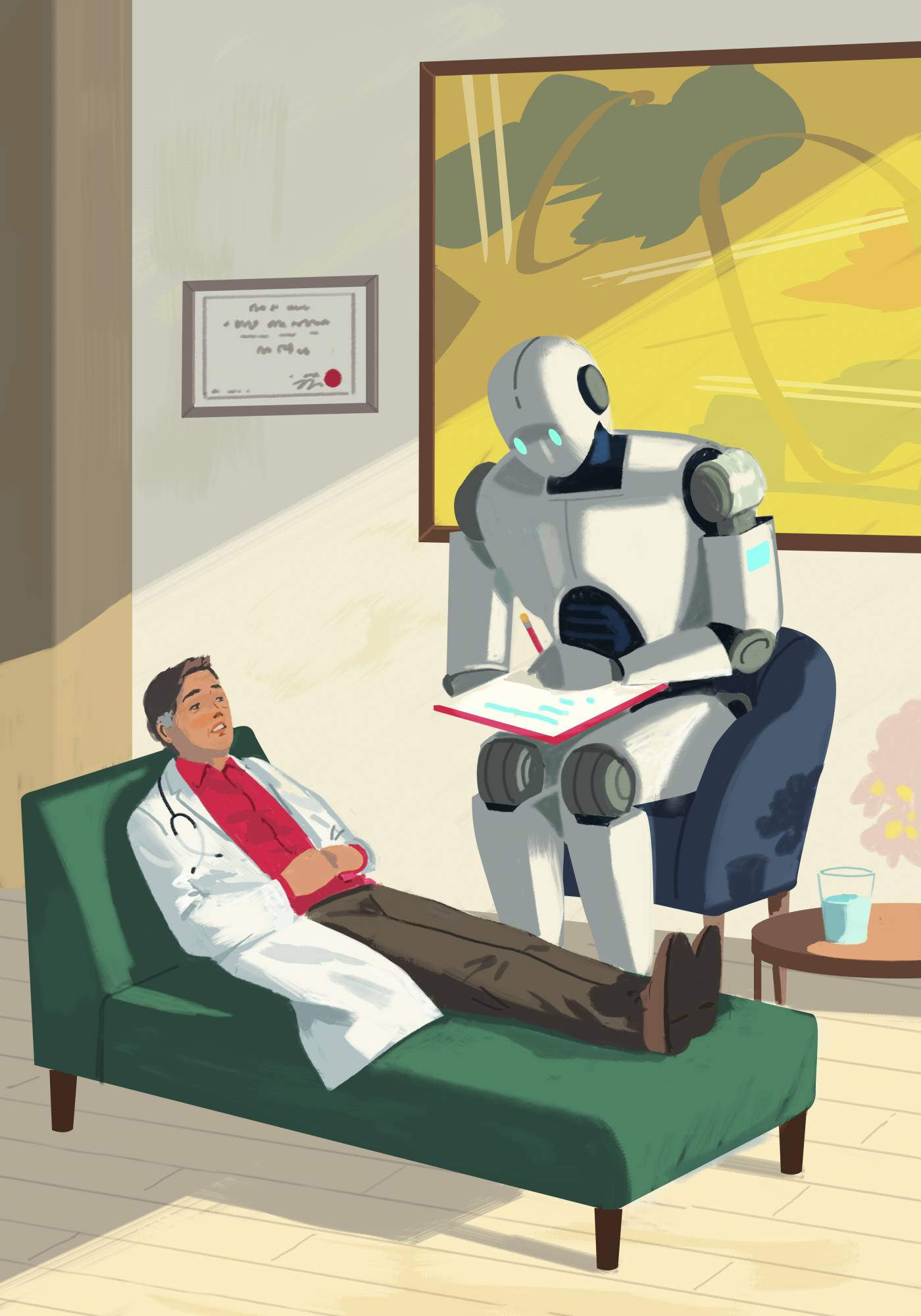

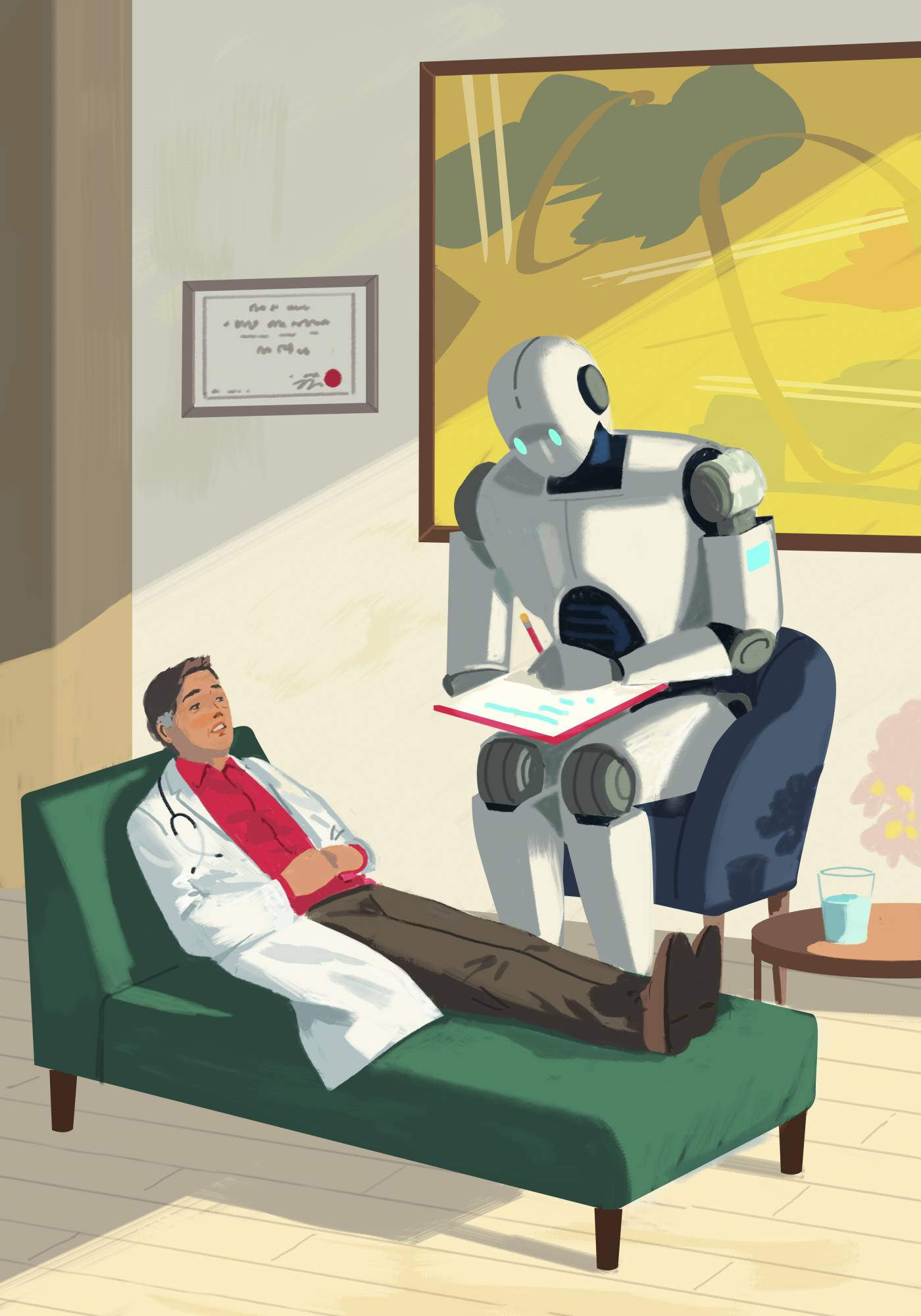

عندما يحين وقت إجراء محادثة صعبة مع مريض يحتضر، حول تركيب أنبوب تغذية في جسمه، يتدرب الدكتور جوناثان تشين، طبيب الباطنية في جامعة ستانفورد، أولاً مع برنامج دردشة آلي. فهو يطلب من البرنامج أن يلعب دور الطبيب بينما يتقمص هو دور المريض، ثم يعكس الأدوار.

براعة الذكاء الاصطناعي الفائقة

يشعر الدكتور تشين بعدم الارتياح حيال ذلك، فبرنامج الدردشة الآلي بارعٌ في إيجاد طرق للتواصل مع المرضى. كما يعلم الأطباء أيضاً براعته في التشخيص وقراءة الصور والفحوص – بل إنه أفضل من كثير من الأطباء – وكذلك في الإجابة عن أسئلة المرضى عبر البوابات الإلكترونية وكتابة طلبات الاستئناف لشركات التأمين عند رفض دواء أو إجراء طبي.

ما هي وظيفة الطبيب؟

إذن، ما هي وظيفة الطبيب؟ يجيب تشين بأن برامج الذكاء الاصطناعي باتت تُشكل «تهديداً وجودياً» للأطباء؛ فهي «تُهدد هويتهم ورسالتهم».

ويتفق الدكتور هارلان كرومولز، طبيب القلب في جامعة ييل ومستشار برنامج OpenEvidence، وهو برنامج ذكاء اصطناعي للأطباء، مع هذا الرأي.

ويضيف كرومولز، وهو أيضاً أحد مؤسسي شركتين ناشئتين تستخدمان الذكاء الاصطناعي لتحليل الصور الطبية والبيانات الرقمية: «إن قدرة الذكاء الاصطناعي على التفكير والتشخيص تتجاوز بالفعل قدرات الأطباء».

الذكاء الاصطناعي بدأ يُغير ممارسات بعض الأطباء

وقد عمل الكثير من الأطباء الذين فكروا ملياً في دور الذكاء الاصطناعي في الطب، مع شركات متخصصة في هذا المجال. وتشين واحد من هؤلاء الأطباء، ويقول إنه والكثير من زملائه يضطرون إلى التساؤل: «متى سيحين الوقت أمامهم للتخلي عن التدخل وترك الأمور للحاسوب؟».

ويقول الباحثون إن برنامجاً مطوراً منظراً مثل «دكتور تشات بوت» Dr. Chatbot ليس جاهزاً تماماً لاستقبال المرضى الآن. لكن الذكاء الاصطناعي بدأ يُغير ممارسات بعض الأطباء ونوعية المرضى الذين يعالجونهم.

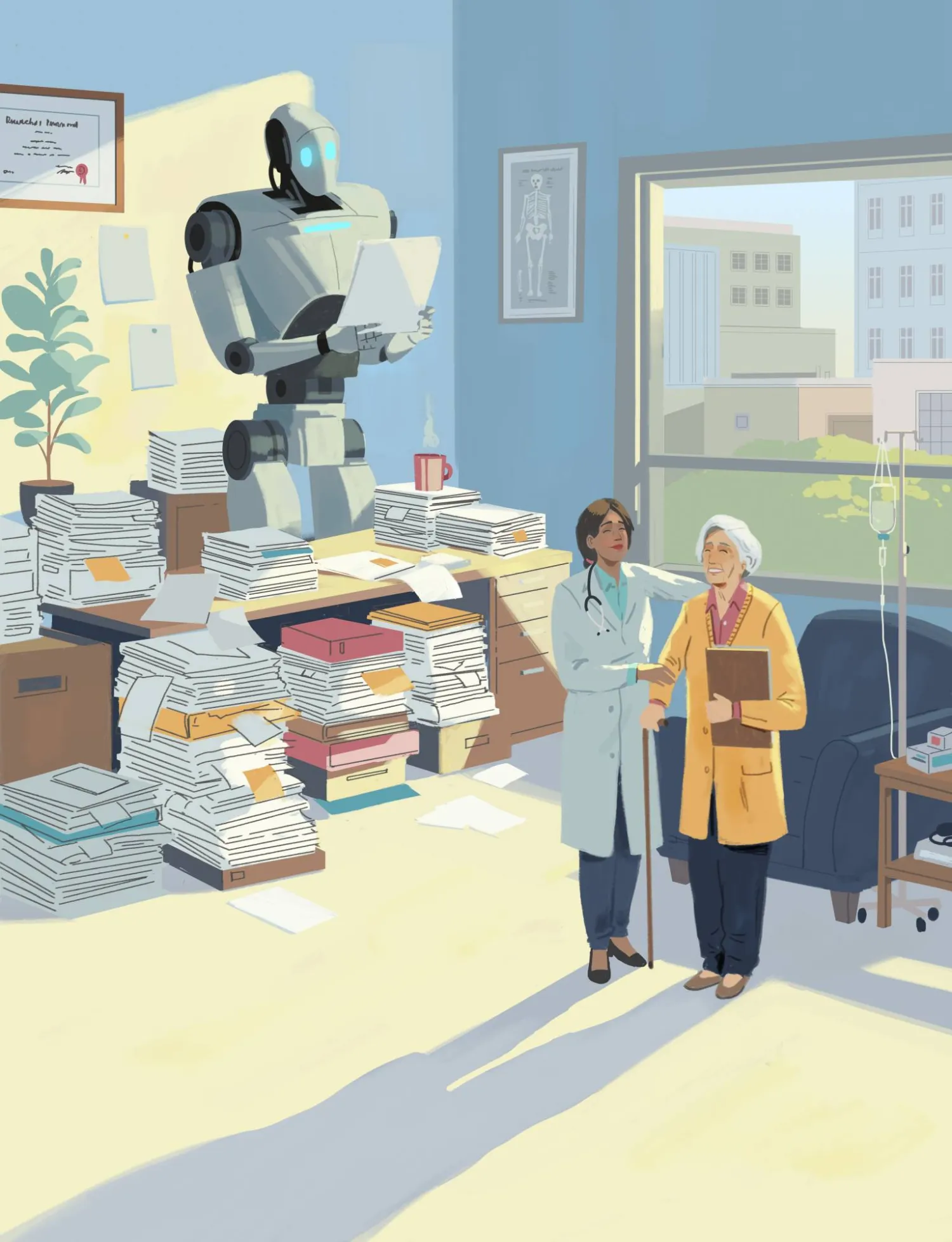

أولوية الرعاية... بيد الطبيب

يقول الدكتور روبرت كاليف، طبيب القلب بجامعة ديوك والمفوض السابق لإدارة الغذاء والدواء الأميركية، إن الذكاء الاصطناعي يتولى ما وصفه بـ«بعض الأعمال الروتينية» التي يقوم بها الأطباء حالياً، مثل تدوين ملاحظات حول زيارات المرضى. ولكن حتى مع وجود كم هائل من المعرفة الطبية في خوادمه، فقد لا يكون ذلك كافياً للسماح للروبوتات بتولي رعاية المرضى. وكان كاليف عمل لدى شركة «ألفابت» لمدة ست سنوات، ويقدم استشاراته لشركة ناشئة تستخدم الذكاء الاصطناعي لوصف الأدوية. ويضيف كاليف: «هناك كم هائل من المعلومات، إلا أن كيفية إجراء التفكير النقدي فيها أمر معقد».

رصد الحالة المرضية بدقة

من جهته، يقدم الدكتور لي شوام، طبيب الأعصاب والعميد المساعد للاستراتيجية الرقمية والتحول في كلية الطب بجامعة ييل، مثالاً على ذلك.

يقول المريض: «استيقظتُ أمس وأنا أشعر بدوار. كانت ذراعي مخدرة، وواجهتُ صعوبة في الكلام». ماذا يعني «الدوار» تحديداً؟ قد يعني أن المريض يشعر بدوار خفيف وعلى وشك الإغماء. أو قد يعني أن الغرفة تدور من حوله.

قد يكون المقصود بـ«الذراع الميتة» هو التنميل لا الضعف. قد يصف شخص مصاب بشلل جزئي في ذراعه شعوره بالتنميل. لكن المريض قد يشعر بوخزة إبرة إذا وخزه الطبيب شوام.

هل أصيب المريض بجلطة دماغية؟ هل هذه حالة طبية طارئة؟ يقول شوام إن لديه سنوات من التدريب تُساعده على تحديد المرضى، ومن لا داعي للقلق بشأنه، ومن يجب إدخاله إلى المستشفى... لقد تعلم قراءة العلامات الدقيقة واستخلاص المعلومات التي يصعب التعبير عنها بوضوح والتي نادراً ما تُدوّن.

ويضيف شوام أنه «يستطيع استخدام المنطق في ظل معلومات محدودة أو غير كاملة لاختيار التشخيصات الأكثر ترجيحاً لمزيد من التقييم، مع الموازنة بين الدقة والواقعية».

المصابون بأمراض خطيرة يحتاجون إلى تواصل إنساني

إن هذا العمل ليس من اختصاص برامج الدردشة الآلية. لذا؛ كما يقول شوام: «إنها بارعة في مطابقة الأنماط والتنبؤ... لكن لا يمكنها فعل ذلك إلا بناءً على البيانات المُعطاة لها عن المريض. ليس لديها أي وسيلة لاستخلاص تلك المعلومات بنفسها». ويضيف أن المصابين بأمراض خطيرة يحتاجون إلى تواصل إنساني. ويتابع: «في النهاية، فإنك تريد أن تنظر في عيني المريض»، وأن تشرح له ما إذا كان أمامه عشر سنوات ليعيشها أم ستة أشهر فقط.

الأدوات الذكية تخفف عمل الأطباء الاختصاصيين

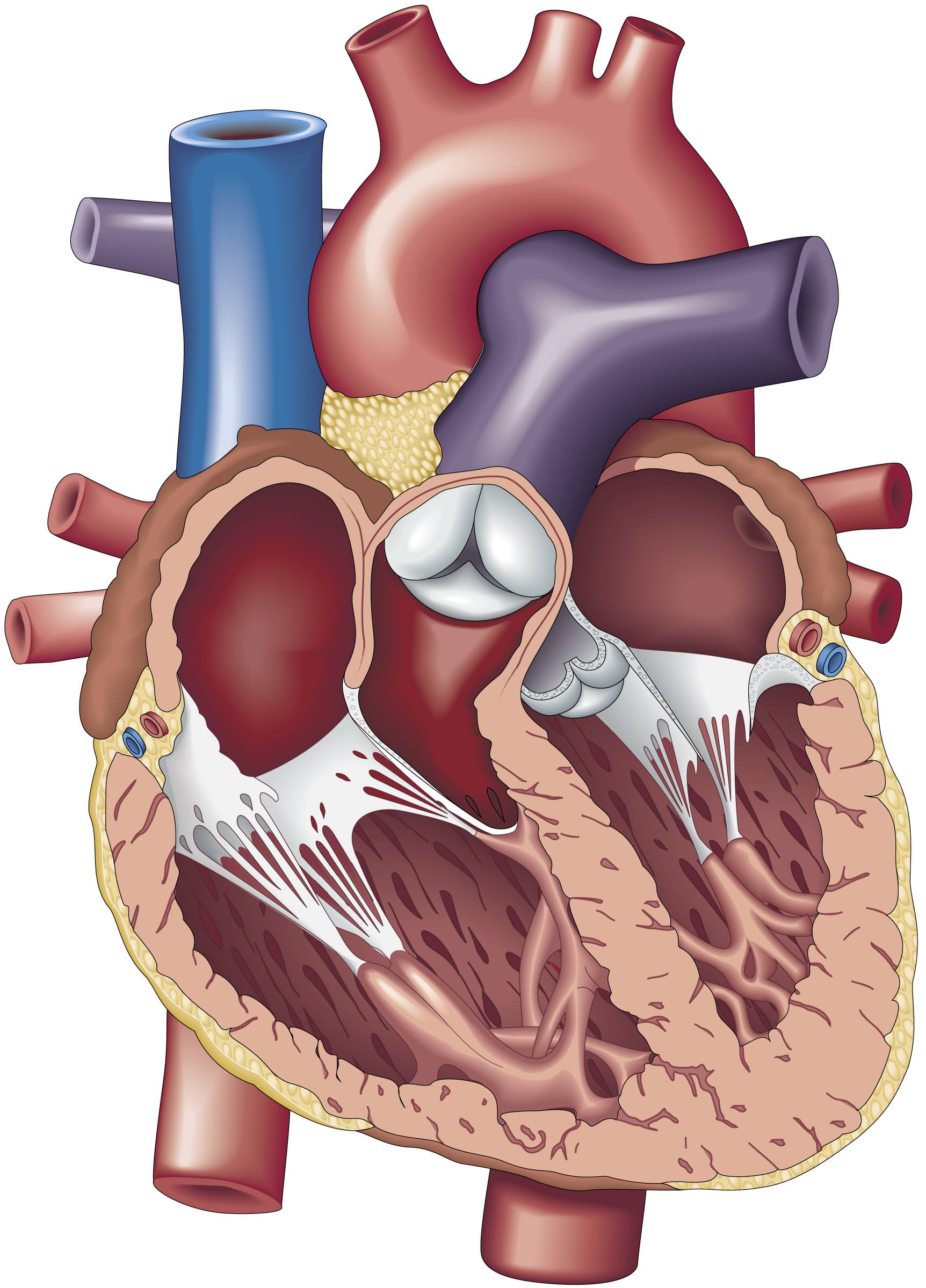

لكن شوام لا يستبعد قدرات برامج الدردشة الآلية، التي يُقرّ بأنها قادرة على توسيع نطاق وصول الأطباء وتغيير بنية نظامنا الصحي. ويقول إن الذكاء الاصطناعي يتفوق بالفعل على الأطباء في بعض الحالات، مثل قراءة تخطيط كهربائية القلب. فهو قادر على تشخيص أمراض القلب من خلال رصد أنماط لا يستطيع أطباء القلب رؤيتها، والتي تتطلب عادةً إجراء تخطيط صدى القلب المكلف. وهذا يعني أن أطباء الأسرة يمكنهم الآن القيام ببعض مهام أطباء القلب.

كما يُسهم الذكاء الاصطناعي في تخفيف عبء العمل على بعض الاختصاصيين الطبيين، بحيث لا يضطر المرضى الذين يحتاجون إلى خبرتهم إلى الانتظار أسابيع أو شهوراً للحصول على موعد.

برامج لرصد أعراض الارتجاع المريئي

هذا ما يحدث بالفعل في عيادة الدكتور جون إريك باندولفينو، اختصاصي الارتجاع المرييي المعدي (GERD) في كلية فاينبرغ للطب بجامعة نورث وسترن.

كان معظم المرضى الذين يعانون أعراض ارتجاع المريء ينتظرون أسابيع للحصول على موعد معه. وأوضح أن «نسبة كبيرة من الحالات» كانت أقل خطورة ولا تتطلب رعايته.

*رصد الحالات المرضية. ابتكر باندولفينو حلاً يعتمد على الذكاء الاصطناعي أطلق عليه اسم GERDBot. يقوم النظام بفرز المرضى، وتوجيه من لا يحتاجون فعلاً إلى زيارة الطبيب إلى مقدمي رعاية صحية آخرين. والهدف هو تسريع علاج من يعانون أعراضاً أكثر خطورة.

يبدأ المرضى بالإجابة عن أسئلة النظام الآلي. ومن تظهر عليهم أعراض تشير إلى مشكلة خطيرة، يخضعون للفحص فوراً. أما الباقون، فيتلقون اتصالاً خلال أسبوع من ممرضة ممارسة أو مساعد طبيب، يُطمئنهم ويصف لهم الأدوية اللازمة، إن لزم الأمر.

ويستقبل باندولفينو، الذي رخص نموذج ذكاء اصطناعي آخر من ابتكاره لشركة الأجهزة الطبية «ميدترونيك»، الآن عدداً أقل من المرضى، لكنهم هم من يحتاجون إلى خبرته. ويقول: «معظم الناس يُقدّرون حقيقة أن علاجهم قد ابتدأ بالفعل، وحصولهم على المعلومات فوراً، وإذا لم يستجب علاجهم أو ظهرت عليهم علامات تحذيرية، فانهم يُحالون إلى الطبيب».

ويُقرّ بأن قلة قليلة تشعر بأنها تُحال إلى رعاية أقل جودة. لكن الطريقة القديمة - التي كانت تتطلب انتظاراً يصل إلى ستة أشهر للحصول على موعد - كانت أسوأ بكثير لمن يرغبون في المساعدة والطمأنينة.

* رصد الأعراض الحادة. وكانت الخطوة التالية تخفيف العبء عن المرضى الذين يعانون أعراض ارتجاع المريء الحادة. وقد طوّر باندولفينو خوارزمية ذكاء اصطناعي أطلق عليها اسم «إيزو-إنستين» Eso-Instein (Eso اختصاراً لكلمة «مريء»)، التي ستساعد اختصاصي الجهاز الهضمي الأقل تخصصاً على تحديد التشخيص الأرجح بناءً على أعراض المريض، ونتائج التنظير الداخلي، والفحوص الفيزيولوجية. ثم تُخبر الخوارزمية الطبيب بكيفية علاج المريض وتوقعات سير المرض.

ويقول باندولفينو: «في نهاية المطاف، عندما تتفوق الخوارزمية على الإنسان، سأضطر إلى البحث عن عمل آخر». ويضيف: «سيجعل الذكاء الاصطناعي أمثالي أقل أهمية تدريجياً».

كما أن خوارزمية الذكاء الاصطناعي التي ابتكرها باندولفينو قد تُتيح للاختصاصيين إحالة الكثير من مرضاهم إلى أطباء الرعاية الأولية، يُؤمل أيضاً أن تُسهم هذه الاستراتيجية نفسها في زيادة توافر أطباء الرعاية الأولية من خلال إسناد بعض مهامهم إلى ممرضين متخصصين. إذ إن هناك نقصاً حاداً في أعداد أطباء الرعاية الأولية، لا في المناطق الريفية فحسب، بل حتى في المدن الكبرى التي تضم كثيراً من المستشفيات وكليات الطب الكبيرة.

ارتقاء دور الممرضين... بفضل الذكاء الاصطناعي

الذكاء الاصطناعي يمكنه أن يساعد المرضى، كما قال الدكتور آدم رودمان، طبيب باطني في مركز بيث إسرائيل ديكونيس الطبي، بفرز المرضى وتمكين الممرضين الممارسين من القيام بجزء أكبر من عمل طبيب الرعاية الأولية؛ ما يتيح للطبيب معاينة المزيد من المرضى ذوي الاحتياجات المعقدة. وعندما يتعلق الأمر بالاختيار بين طبيب لا يستقبل مرضى جدداً أو طبيب يحيل المرضى إلى ممرض ممارس أو مساعد طبيب، فمن المرجح أن يتقبل المرضى هؤلاء المتخصصين الطبيين الآخرين.

مع ذلك، يُقرّ رودمان وباحثون آخرون بوجود مخاطر تتمثل في إمكانية أن تُعيد برامج الدردشة الآلية إنتاج التحيزات الموجودة بالفعل في المؤسسات الطبية. فعلى سبيل المثال، وجدت إحدى الدراسات أنها قد تُولي اهتماماً أقل لامرأة أو لشخص يرتكب أخطاءً إملائية أو نحوية.

مخاوف الخبراء من قصور النظام الطبي

تدفع هذه المخاوف بعض الخبراء إلى التحذير من عدّ الذكاء الاصطناعي حلاً سحرياً للنظام الطبي. يقول الدكتور ليو أنتوني سيلي، مدير الأبحاث السريرية في مختبر علم وظائف الأعضاء الحاسوبي بمعهد ماساتشوستس للتكنولوجيا: «إن القلق الحقيقي ليس في الذكاء الاصطناعي بحد ذاته، بل في استخدامه لتحسين نظام معيب بشدة بدلاً من إعادة تصوره». ويضيف سيلي: «قد لا يُدرك مرضى اليوم مدى قصور النظام الحالي في تلبية احتياجاتهم».

وتشاركه زميلته، مرضية قاسمي من مجموعة التعلم الآلي الصحي في معهد ماساتشوستس للتكنولوجيا، في مخاوف مماثلة؛ إذ قالت إن الذكاء الاصطناعي يمتلك «إمكانات هائلة»، لكن يبدو أنه يُستخدم حالياً في الغالب لزيادة أرباح الأنظمة الطبية من خلال «رفع ثمن الفواتير، واستبدال كوادر الرعاية الصحية الأولية للمرضى المحتاجين، أو الترويج للأدوية:».

وقال رودمان، إن على الأنظمة الطبية ومرضاها أن يكونوا على دراية بهذه المشكلات. وأضاف: «لكن هذا ليس سبباً للتخلي عن هذه التقنية». وهو يأمل أن يتمكن الباحثون، بفضل الذكاء الاصطناعي، من توثيق التحيزات والحد منها. أما مع البشر، الذين لديهم التحيزات نفسها، «فمن الصعب جداً التخفيف منها»، كما قال رودمان.

وأضاف رودمان أن الذكاء الاصطناعي، على الأقل في بعض المهام، سيكون أفضل من الأطباء. سيكون أكثر دقة في الالتزام بإرشادات الفحص وتقديم المشورة للمرضى بشأن عادات نومهم وغذائهم، على سبيل المثال.

آخر ما نريده: «طبيب غبي يعتمد على الذكاء الاصطناعي بالكامل»

ويعلق يقول الدكتور جيفري أ. ليندر، اختصاصي الطب الباطني في جامعة نورث وسترن. على ذلك بأن «هذه هي الجوانب الروتينية في مهنة الطب».

ويضيف: «هناك الكثير من المهام التي نقوم بها في الرعاية الصحية الأولية والتي تبدو وكأنها مجرد إجراءات شكلية». ولكنه أعرب عن قلقه من أن يعتمد بعض الأطباء بشكل مفرط على الذكاء الاصطناعي، ويقول: «آخر ما نريده هو طبيب غبي يعتمد على الذكاء الاصطناعي بشكل كامل»، حيث «أُعطّل عقلي وأترك الذكاء الاصطناعي يملي عليّ ما يجب فعله طوال الوقت».

لكن المشكلة تكمن في أنه بينما قد لا يكون الذكاء الاصطناعي مثالياً، فإن النظام الطبي الحالي ليس كذلك أيضاً. ويتضح جلياً أن دور الطبيب سيشهد تحولاً جذرياً.

الدور المهم للأطباء

لكن لا يزال للأطباء أدوار مهمة يؤدونها. ويقول ليندر: «الطب الباطني تخصصٌ يعتمد على التعامل المباشر مع المرضى. إنك تتعرف على مرضاك بمرور الوقت، وتعرف قيمهم، وتعرف عائلاتهم».

ويوافق الدكتور جوشوا شتاينبرغ، طبيب الرعاية الأولية في جامعة ولاية نيويورك الطبية في بينغهامتون، نيويورك، على ذلك. ويقول: «حتى لو قرأ الذكاء الاصطناعي جميع المراجع الطبية، سأظل أنا الخبير في حالة مرضاي». ويضيف: «أعتقد أن دورنا كأطباء قد يبدو مختلفاً بعض الشيء، لكنني سأظل جالساً على كرسي متحرك صغير، أتحدث مع المريض».

* خدمة «نيويورك تايمز»