لطالما دار النقاش حول الذكاء الاصطناعي في إطار الابتكار والفرص والتحولات الكبرى، لكن الأحداث الأخيرة سلّطت الضوء على مخاطره حين يُستخدم من دون ضوابط كافية. فقد كشفت تقارير دولية هذا الشهر عن وفاة مراهق يبلغ من العمر 16 عاماً بعد أن تحدّث مع برنامج «تشات جي بي تي» عن أفكاره لإيذاء نفسه، ما أثار تساؤلات عميقة حول تأثير هذه التكنولوجيا.

وقد رفع والدا المراهق دعوى قضائية في ولاية كاليفورنيا الأميركية، اتهما فيها شركة «أوبن أيه آي» بالتسبب في وفاة ابنهما، مؤكدين أن برنامج «تشات جي بي تي» التابع للشركة شجعه على الانتحار.

وفي خطوة سريعة، أعلنت شركة «أوبن إيه آي» عن إطلاق سلسلة من أدوات الرقابة الأبوية وإجراءات جديدة للسلامة، مؤكدة أن هذه القرارات ليست مجرد ردّ على حادثة بعينها، بل جزء من التزام أوسع بحماية المستخدمين، خصوصاً الأطفال والمراهقين.

ضوابط أبوية لحماية الفئات الأصغر

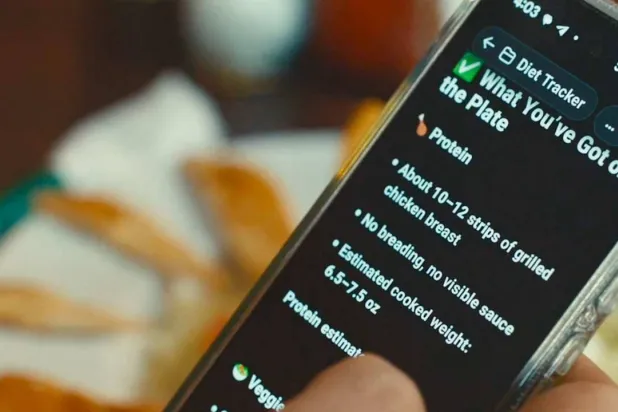

أكدت الشركة أن أدوات الإشراف الأسري ستصبح قريباً متاحة في «تشات جي بي تي»، بحيث تتيح للآباء تحديد حدود الاستخدام، وحجب المواضيع الحساسة، ومتابعة نشاط الحسابات. الهدف، وفق الشركة، هو بناء ثقة أكبر في بيئة أصبحت فيها أدوات الذكاء الاصطناعي جزءاً من المدارس والمنازل ووسائل التواصل الاجتماعي، فيما يندفع صغار السن لاستخدامها بكثافة.

وقالت «أوبن إيه آي» في بيان: «مسؤوليتنا أن نضمن أن يخدم الذكاء الاصطناعي الناس بشكل إيجابي، وخاصة الفئات الأكثر ضعفاً».

من مأساة فردية إلى تحوّل مؤسسي

ورغم أن حادثة وفاة المراهق تبقى نادرة، فإنها شكّلت صدمة دفعت الحكومات والهيئات التنظيمية في أوروبا وآسيا والشرق الأوسط إلى المطالبة بضوابط أكثر صرامة على تفاعل الذكاء الاصطناعي مع القُصّر. تحرك «أوبن إيه آي» السريع يعكس إدراكها لحجم المخاطر الأخلاقية والسمعة المرتبطة بالموضوع، ويشير إلى أن الشركة لا تستطيع تأجيل سدّ هذه الفجوات.

ويرى خبراء أن هذه اللحظة قد تمثل نقطة انعطاف في مسار الصناعة. إذ قال أحد الباحثين: «لم يعد كافياً أن تدفع شركات الذكاء الاصطناعي الابتكار إلى الأمام؛ عليها أن تفكر أيضاً في العواقب غير المقصودة، خاصة حين يتعلق الأمر بالأطفال».

طبقات متعددة للسلامة

إلى جانب الضوابط الأبوية، أوضحت «أوبن إيه آي» أن منظومتها تعتمد على بنية دفاعية متعددة المستويات تبدأ بتدريب النماذج على رفض الطلبات المؤذية المرتبطة بالعنف أو إيذاء النفس وخطاب الكراهية، مروراً بأنظمة آلية ترصد المحادثات وتطلق تنبيهات عند ظهور مؤشرات خطورة، وصولاً إلى مراجعة بشرية للحالات الحرجة عند الحاجة، مع تعزيز ذلك بشراكات مع خطوط المساعدة والمنظمات غير الحكومية لتقديم موارد دعم فوري مثل أرقام الوقاية من الانتحار. وتؤكد الشركة أن هذه الإجراءات ليست مجرد مخططات، بل مطبّقة بالفعل في المنظومة، وتوسّع حالياً استناداً إلى الدروس المستفادة من الحوادث الأخيرة.

وفي هذا السياق، اعترف سام ألتمان، الرئيس التنفيذي لـ«أوبن إيه آي»، بأن بعض المستخدمين وخاصة الشباب بدأوا يتعاملون مع «تشات جي بي تي» كما لو كان مدرباً شخصياً أو مستشاراً للحياة. ورغم أنه رأى في ذلك دليلاً على فاعلية التكنولوجيا، فإنه حذّر في أكثر من مناسبة من خطورة الاعتماد المفرط على الذكاء الاصطناعي لاتخاذ قرارات مصيرية، مؤكداً أن الحكم البشري لا يمكن استبداله.

البشر في قلب المخاطر

يتقاطع توقيت هذه الإجراءات مع اتجاه عالمي متزايد نحو التركيز على «المخاطر البشرية». ففي مجالات مثل الأمن السيبراني، يُنظر إلى الخطأ البشري على أنه الحلقة الأضعف، والآن يمتد هذا المفهوم إلى الذكاء الاصطناعي. إدراك «أوبن إيه آي» أن المستخدمين أنفسهم وليس فقط الخوارزميات هم نقطة الضعف، يمثل تحوّلاً نحو مفهوم «السلامة المتمحورة حول الإنسان».

كما تأتي هذه التطورات بينما تعمل جهات تشريعية حول العالم على سنّ قوانين أشد صرامة. الاتحاد الأوروبي قد أدخل معايير إلزامية لحماية الأطفال والولايات المتحدة تناقش أُطر مشابهة، فيما تضع السعودية والإمارات مدونات أخلاقية للذكاء الاصطناعي تراعي القيم الثقافية والاجتماعية.

وبإعلانها عن أدوات إشراف أبوي، تبعث «أوبن إيه آي» برسالة واضحة إلى المنظمين: نحن لا ننتظر فرض التشريعات، بل نتحرك استباقياً. وهذا قد يدفع منافسين كباراً مثل «غوغل ديب مايند» و«ميتا» و«أنثروبيك» إلى تسريع جهودهم في هذا الاتجاه.

ثقة المستخدمين أساس الانتشار

مع دخول الذكاء الاصطناعي إلى الصفوف الدراسية والمكاتب وقطاع الصحة، يثار التساؤل عن قابلية الناس لتبنيه على نطاق واسع قبل اطمئنانهم إلى أنه آمن لهم ولأبنائهم. ويحذر محللون من أن أي تقصير في هذا الجانب قد يهدد ليس فقط سمعة الشركات بل شراكاتها مع الحكومات والمؤسسات التعليمية والصحية. ومن ثمّ، فإن السلامة لم تعد مجرد مسؤولية أخلاقية، بل استراتيجية عمل أساسية.

تَعِد «أوبن إيه آي» بمزيد من التحديثات على خريطة طريقها للسلامة خلال الأشهر المقبلة، مع إشراك المربين والآباء وجماعات المجتمع المدني في صياغة السياسات. وتؤكد أن «السلامة لا يمكن بناؤها في عزلة».

ومع ذلك، فإن حادثة المراهق الذي فقد حياته ستبقى تذكيراً مؤلماً بما هو على المحك. فقد أظهرت أن الذكاء الاصطناعي ليس مجرد وسيلة للإنتاجية أو الإبداع، بل يمكن أن تكون له تبعات تمسّ حياة البشر مباشرة.

وإذا كان هذا الحادث المأساوي قد شكّل الشرارة الأولى، فإن الاختبار الحقيقي سيكون فيما إذا كانت هذه الوعود ستتحول إلى التزام دائم يضع الإنسان في قلب الابتكار.