الصيف الماضي، ظهر إعلانٌ في آلاف الصفحات على «فيسبوك»، تضمن فيديو مُعدّلاً للمتحدثة باسم البيت الأبيض، كارولين ليفيت، في مؤتمر صحافي دوري.

إعلانات مفبركة

وفي الإعلان، بدت وكأنها تقول إنه بإمكان الأميركيين الحصول على شيك إغاثة بقيمة 5000 دولار أميركي عبر موقع حكومي رسمي. ثم ظهر سهمٌ آخر، قاد إلى مُعلن يدعى «Get Covered Today».

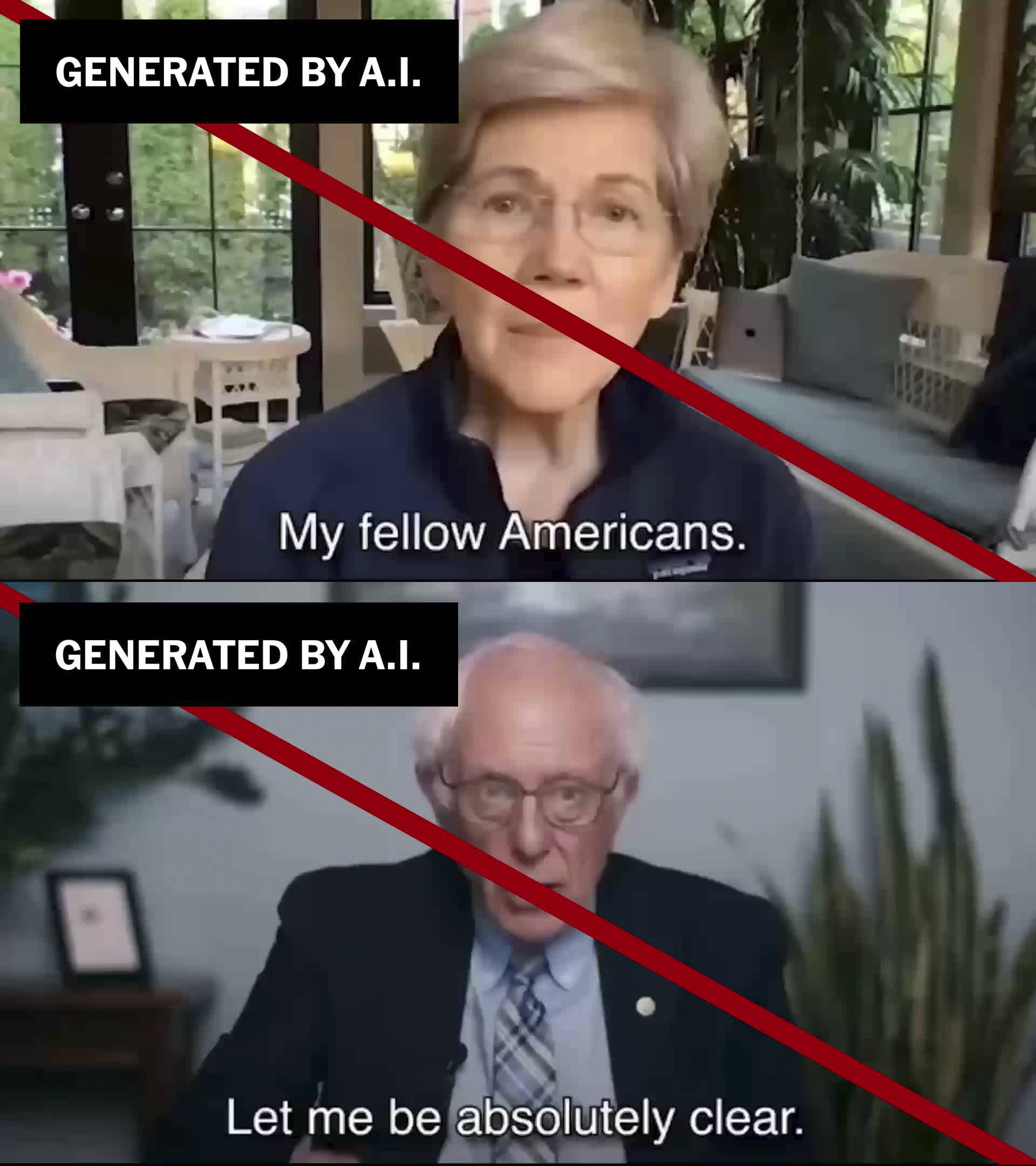

وقد عرضت إعلاناتٌ مماثلة مقاطع فيديو مُفبركة للسيناتور بيرني ساندرز من ولاية فيرمونت والسيناتورة إليزابيث وارن من ولاية ماساتشوستس، وهما يعدان بخصوماتٍ مماثلة غير موجودة. يقول مُنتحل شخصية وارن: «هذه ليست خدعة»... وفي الواقع، فإنها كانت كذلك.

ومع ذلك، كانت الشركة التي تقف وراء الإعلانات وغيرها من الإعلانات المماثلة من بين أبرز المُعلنين السياسيين على «فيسبوك»، وفقاً لتحليلٍ أجراه مشروع الشفافية التقنية، وهو منظمة غير ربحية تُركز على مُحاسبة شركات التكنولوجيا الكبرى.

الإعلانات - عائدات مربحة

تُعدّ الإعلانات جزءاً مُربحاً من عائدات إعلانات «فيسبوك»، التي يقول باحثو المشروع وآخرون إنها دفعت الشركة إلى غضّ الطرف عن سيلٍ من المحتوى رديء الجودة أو المُضلّل، والرسائل غير المرغوب فيها، وفي بعض الحالات الاحتيال الصريح على المنصة.

معلنون أغنياء يمارسون التضليل

وصرحت كاتي أ. بول، مديرة مشروع الشفافية التقنية، قائلةً: «إن شركة ميتا على دراية تامة بهذه الأنواع من عمليات الاحتيال. لكنها لا تبالي».

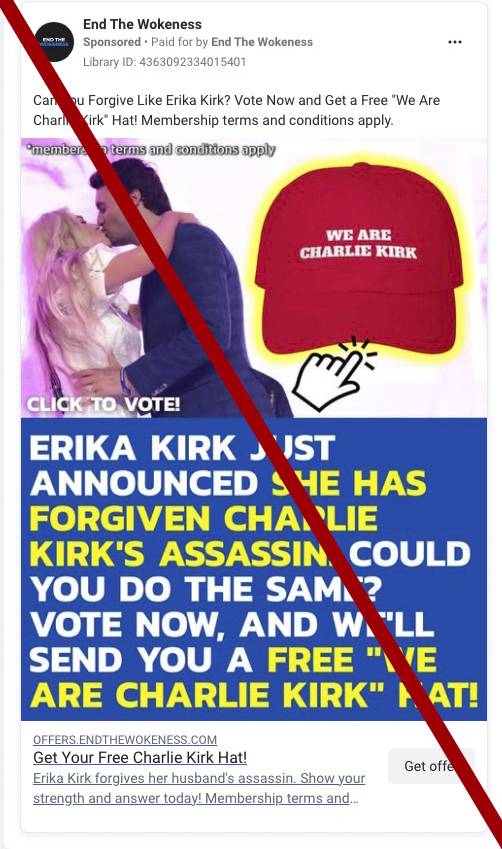

وفي تقرير صدر يوم أمس الأربعاء، حدد المشروع 63 مُعلناً استخدموا، وفقاً لعدة مقاييس، ممارساتٍ مُضلّلة أو احتيالية. يُشكّل هؤلاء المعلنون نسبة واحد من كل خمسة من بين أكبر 300 مُنفق على المنصة في فئة الإعلانات السياسية أو الاجتماعية.

وكان هؤلاء المعلنون اشتروا مجتمعين ما يقرب من 150 ألف إعلان، وأنفقوا ما يقرب من 49 مليون دولار على مدى السنوات السبع الماضية، وفقاً لبيانات مكتبة إعلانات «فيسبوك».

وقد أُزيلت إعلانات جميع المُعلنين الـ63 سابقاً لانتهاكهم سياسات «فيسبوك»، مما يعني أن ممارساتهم المُضلّلة لم تكن مجهولة. وأوقفت شركة «ميتا» بعض هذه الحسابات، لكن أكثر من نصفها تمكّن من مواصلة نشر إعلانات جديدة حتى هذا الأسبوع.

«ميتا» أرباح طائلة... ومحاولات حماية متأخرة

وصرحت وارن في بيان لها حول انتحال شخصيتها: «الأمر الوحيد الأسوأ من استخدام مقاطع فيديو الذكاء الاصطناعي المُزيّفة لخداع الأميركيين هو أن (ميتا) تجني عشرات الملايين من الدولارات من هذه الإعلانات الاحتيالية».

وأضافت: «نحن بحاجة إلى وضع حواجز حماية جدية لحماية المستهلكين على الإنترنت».

يحظر «فيسبوك»، المملوك لشركة ميتا، الإعلانات التي تستخدم «ممارسات خادعة أو مضللة مُحددة، بما في ذلك عمليات الاحتيال لسرقة الأموال من الناس أو الوصول إلى المعلومات الشخصية». ولدى المنصة قواعد واضحة ضد انتحال الشخصية، وقد أزال في النهاية فيديو ليفيت، وإن لم يحذف جميع الفيديوهات الأخرى.

وفي بيان، قالت الشركة إنها تطبق قواعدها بحزم وستستثمر في بناء دفاعات تقنية جديدة ضد ما وصفته بمشكلة على مستوى الصناعة. وجاء في البيان: «المحتالون لا يلينون، ويطورون أساليبهم باستمرار في محاولة للتهرب من الكشف».

مراقبة مضامين الإعلانات آلية... وليست بشرية

لطالما عانت منصة «فيسبوك» من انتقاداتٍ للإعلانات السياسية التي يروج لها على منصته. وهي تفرض شروطاً محددة على المعلنين السياسيين، تشترط عليهم، على سبيل المثال، أن يكونوا شركات مسجلة في الولايات المتحدة. ويقول الخبراء إن عملية إرسال الإعلانات التي تظهر على المنصة والموافقة عليها آلية إلى حد كبير، مما يسمح للجهات غير النزيهة بالتسلل.

أدرج بعض المعلنين الذين دقق فيهم مشروع الشفافية التقنية، معلومات اتصال في الفلبين وبنغلاديش وفيتنام وبريطانيا، وهي الأماكن التي كان من المفترض أن تؤدي إلى استبعادهم.

ويبدو أن العديد من الإعلانات تستهدف المستخدمين الأكبر سناً والمحافظين. وغالباً ما تتفاعل هذه الإعلانات بسرعة مع الأحداث ذات الصبغة السياسية.

توظيف الذكاء الاصطناعي في التضليل

تتجاوز عمليات الاحتيال على منصات التواصل الاجتماعي وغيرها من المواقع الإلكترونية بكثير تلك التي تستخدم الرسائل النصية أو المكالمات الهاتفية. وقد ساهم انتشار الأدوات المتاحة تجارياً التي تستخدم الذكاء الاصطناعي بشكل واضح في زيادة الإعلانات المُضلّلة، مما يُسهّل إنتاجها وانتشارها.

قال ساندرز في بيان رداً على استفسار حول التزييف العميق له: «هذا جزء من مشكلة أكبر بكثير: الذكاء الاصطناعي يتقدم بسرعة، لكن القوانين والحماية التي نضعها للأميركيين العاديين أصبحت قديمة بشكل خطير».

هذا وعلّقت شركة ميتا حسابات اثنين من المعلنين الأربعة المعنيين في أغسطس (آب) الماضي، على الرغم من أنهما كانا يُعلنان منذ أسابيع في ذلك الوقت. ويبدو أن حسابين آخرين قد أُزيلا هذا الأسبوع بعد استفسارات حول بحث مشروع الشفافية التقنية.

يقول الباحثون إن بإمكان «ميتا» بذل المزيد من الجهود للحد من مثل هذه الإعلانات وأن تكون أكثر شفافية بشأن تطبيق قواعدها الخاصة. بدلاً من ذلك، تراجعت عن جهودها لضبط المحتوى السياسي وقلصت عدد فرقها العاملة على سلامة المنصة.

* خدمة «نيويورك تايمز».